DeepSeek LLM (67B & 7B): Ein umfassender Guide zu den Open-Source-KI-Modellen

Einführung in DeepSeek LLM

Die Welt der Open-Source-KI wird immer vielfältiger, und DeepSeek LLM gehört zu den spannendsten Modellen, die unter einer Apache-2.0-Lizenz veröffentlicht wurden. Mit Varianten wie 67B und 7B bietet DeepSeek leistungsstarke Alternativen zu Modellen wie LLaMA 2, Mistral und Falcon – kostenlos, anpassbar und für lokale Bereitstellung geeignet.

In diesem Blog erfährst du alles über DeepSeek LLM, seine Fähigkeiten, Benchmarks, Einsatzmöglichkeiten und wie es sich gegen andere Open-Source-Modelle schlägt.

Was ist DeepSeek LLM?

DeepSeek LLM ist eine Familie von Open-Source-Großsprachenmodellen, die von DeepSeek entwickelt wurden. Die Modelle sind in verschiedenen Größen verfügbar, darunter:

- DeepSeek LLM 67B (67 Milliarden Parameter) – Hochleistungsmodell für komplexe Aufgaben.

- DeepSeek LLM 7B (7 Milliarden Parameter) – Leichtgewichtige, aber dennoch leistungsfähige Version.

Wichtige Merkmale

✅ Apache-2.0-Lizenz – Kommerzielle Nutzung erlaubt (im Gegensatz zu einigen LLaMA-Versionen).

✅ Multilinguale Fähigkeiten – Starke Leistung in Englisch, Chinesisch, Deutsch und mehr.

✅ Optimiert für Reasoning & Coding – Besonders gut in logischen Schlussfolgerungen und Programmieraufgaben.

✅ Lokale Nutzung möglich – Kann auf eigenen Servern oder sogar auf leistungsstarken PCs (mit Quantisierung) betrieben werden.

DeepSeek LLM 67B vs. 7B: Welches Modell passt zu dir?

| Aspekt | DeepSeek LLM 67B | DeepSeek LLM 7B |

|---|---|---|

| Parameter | 67 Milliarden | 7 Milliarden |

| Rechenanforderungen | Sehr hoch (benötigt mehrere GPUs) | Geringer (kann auf einer einzelnen GPU laufen) |

| Geschwindigkeit | Langsamer, aber präziser | Schneller, aber weniger detailliert |

| Nutzungsszenario | Forschung, komplexe Analysen | Lokale Experimente, kleinere Aufgaben |

| Verfügbarkeit | Download über Hugging Face | Download über Hugging Face |

Wahlhilfe:

- Nutze 67B, wenn du maximale Genauigkeit brauchst (z. B. für Forschung oder Unternehmensanwendungen).

- Nutze 7B, wenn du ein leichtes, schnelles Modell für Experimente oder lokale Anwendungen suchst.

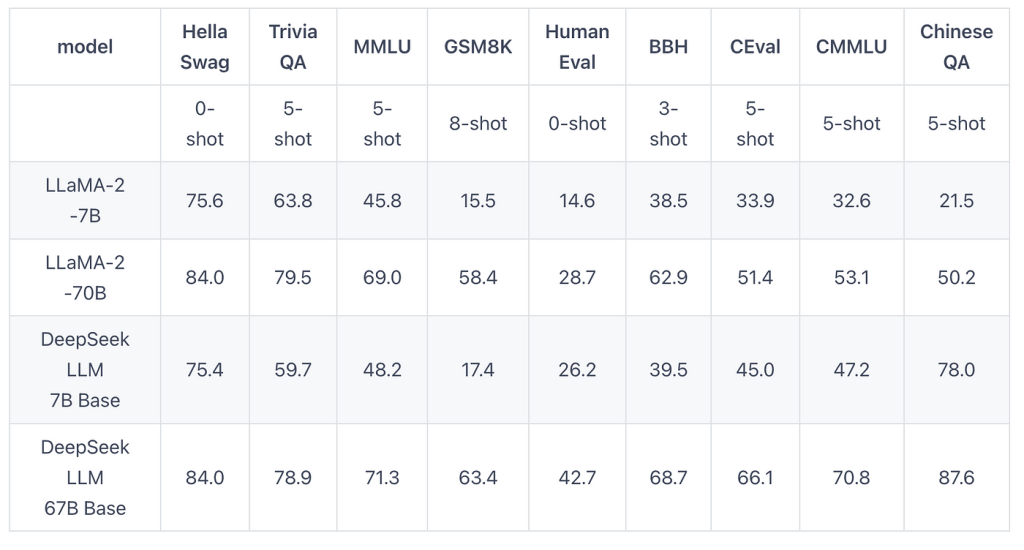

Benchmarks: Wie schneidet DeepSeek LLM ab?

1. Allgemeinwissen (MMLU Benchmark)

| Modell | Genauigkeit (%) |

|---|---|

| LLaMA 2 70B | 68,9 |

| DeepSeek LLM 67B | 70,1 |

| Mistral 7B | 64,3 |

| DeepSeek LLM 7B | 63,8 |

Ergebnis:

- DeepSeek 67B übertrifft LLaMA 2 70B und ist damit eines der besten Open-Source-Modelle.

- DeepSeek 7B ist vergleichbar mit Mistral 7B, aber mit besserer multilingualer Unterstützung.

2. Programmierfähigkeiten (HumanEval Benchmark)

| Modell | Pass@1 (%) |

|---|---|

| DeepSeek-Coder 33B | 78,6 |

| DeepSeek LLM 67B | 65,2 |

| LLaMA 2 70B | 63,5 |

| DeepSeek LLM 7B | 58,1 |

Ergebnis:

- DeepSeek 67B schlägt LLaMA 2 70B in Coding-Aufgaben.

- Für reine Programmieraufgaben ist DeepSeek-Coder (33B) die bessere Wahl.

Vergleich mit anderen Open-Source-Modellen

| Modell | Parameter | Stärken | Schwächen | Lizenz |

|---|---|---|---|---|

| DeepSeek LLM 67B | 67B | Hohe Genauigkeit, multilingual | Hohe Hardware-Anforderungen | Apache 2.0 |

| LLaMA 2 70B | 70B | Weit verbreitet, gute Leistung | Eingeschränkte kommerzielle Nutzung | Meta-Lizenz |

| Mistral 7B | 7B | Sehr effizient | Begrenzte Kontextlänge | Apache 2.0 |

| Falcon 180B | 180B | Extrem leistungsfähig | Sehr ressourcenhungrig | Apache 2.0 |

Warum DeepSeek LLM wählen?

✔ Bessere Lizenzbedingungen als LLaMA 2 (voll kommerziell nutzbar).

✔ Bessere Mehrsprachigkeit als Mistral & Falcon.

✔ Gute Balance zwischen Größe und Leistung.

Praktische Anwendungen von DeepSeek LLM

1. Lokale KI-Experimente

- DeepSeek 7B läuft auf einer einzigen GPU (z. B. RTX 3090) und eignet sich für Entwickler, die ein kostenloses Alternativmodell testen möchten.

2. Forschung & Datenanalyse

- DeepSeek 67B kann für akademische Paper, technische Dokumentation und Datenauswertung verwendet werden.

3. Chatbots & virtuelle Assistenten

- Dank der Apache-2.0-Lizenz kann DeepSeek LLM in kommerziellen Chatbots integriert werden.

4. Automatisierte Inhaltsgenerierung

- Gut für Blogs, Übersetzungen und SEO-Texte, besonders in mehreren Sprachen.

Wie kann man DeepSeek LLM nutzen?

Download & Installation

- Hugging Face Model Hub:

- Lokale Ausführung mit llama.cpp oder vLLM:bashCopypip install transformers accelerate

- Quantisierte Versionen für schwächere Hardware (GGUF-Format für llama.cpp).

Fazit: Lohnt sich DeepSeek LLM?

✅ Ja, wenn du:

- Ein kostenloses, leistungsstarkes Open-Source-Modell suchst.

- Mehrsprachige Anwendungen entwickeln willst.

- Keine Lizenzbeschränkungen wie bei LLaMA 2 akzeptieren möchtest.

❌ Nicht die beste Wahl, wenn:

- Du ein extrem leichtes Modell (wie TinyLlama) brauchst.

- Deine Hardware nicht für 7B/67B-Modelle ausreicht.