DeepSeek-Coder: Die ultimative Open-Source-KI für Programmieraufgaben

Einführung: Was macht DeepSeek-Coder so besonders?

In der schnelllebigen Welt der KI-gestützten Programmierhilfen hat sich DeepSeek-Coder als echter Game-Changer etabliert. Im Gegensatz zu allgemeinen KI-Modellen ist DeepSeek-Coder speziell für Programmieraufgaben optimiert und bietet überragende Fähigkeiten in Code-Generierung, Debugging und Code-Verständnis über mehrere Programmiersprachen hinweg.

Mit den Varianten 1,3B, 6,7B und 33B Parametern bietet diese Modellfamilie skalierbare Lösungen für Entwickler – vom leichtgewichtigen lokalen Einsatz bis zur Hochleistungs-Cloud-Nutzung.

Was ist DeepSeek-Coder?

DeepSeek-Coder ist ein spezialisiertes Open-Weight-LLM für Softwareentwicklung. Es glänzt in:

✅ Code-Vervollständigung – Generiert syntaktisch korrekte Code-Snippets

✅ Fehlerbehebung & Debugging – Erkennt Fehler und schlägt Korrekturen vor

✅ Code-Erklärung – Liefert klare Dokumentation für komplexe Funktionen

✅ Multi-Sprachen-Support – Arbeitet mit Python, Java, C++, JavaScript, Go und mehr

Hauptmerkmale

- Apache-2.0-Lizenz – Kostenlos für kommerzielle und private Nutzung

- Starke Benchmark-Ergebnisse – Übertrifft viele ähnlich große Modelle

- Optimierte Effizienz – Das 1,3B-Modell läuft auf einfacher Hardware, während die 33B-Version proprietären Tools wie GitHub Copilot Konkurrenz macht

DeepSeek-Coder Modellvarianten (1,3B vs. 6,7B vs. 33B)

| Modell | Parameter | Ideal für | Hardware-Anforderungen |

|---|---|---|---|

| DeepSeek-Coder 1,3B | 1,3B | Leichtgewichtige Code-Hilfe, lokale IDE-Integration | CPU / Einfache GPU |

| DeepSeek-Coder 6,7B | 6,7B | Ausgewogene Leistung für kleine Teams | Mittelklasse-GPU (z.B. RTX 3060) |

| DeepSeek-Coder 33B | 33B | Unternehmensweite Code-Generierung | High-End-GPU (z.B. A100) oder Multi-GPU-Setup |

Welches Modell sollten Sie wählen?

- Für persönliche Nutzung & leichte Code-Hilfe → 1,3B

- Für kleine Teams & bessere Genauigkeit → 6,7B

- Für professionelle KI-Programmierhilfe → 33B

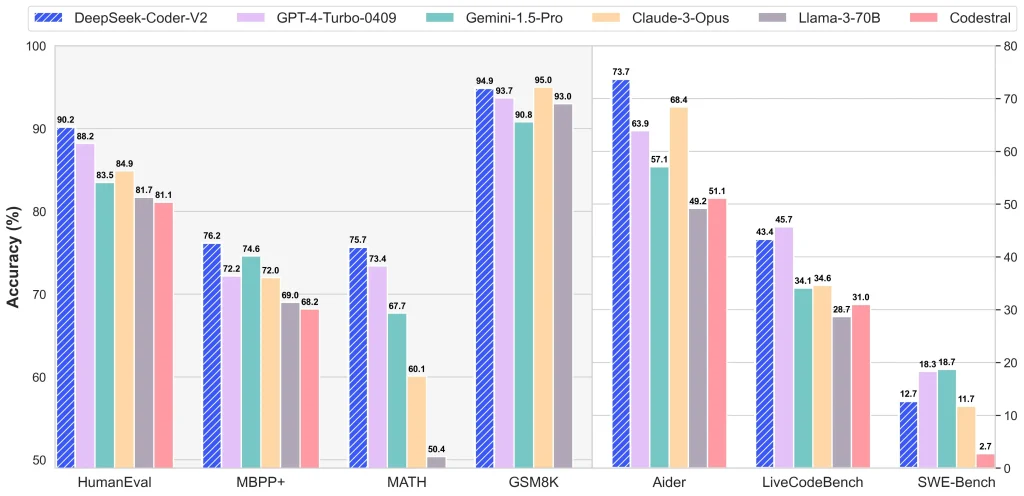

Benchmark-Leistung: Wie schneidet es ab?

1. HumanEval (Python-Code-Generierung)

| Modell | Pass@1 Score (%) |

|---|---|

| DeepSeek-Coder 33B | 78,6 |

| Code Llama 34B | 76,5 |

| StarCoder 15B | 70,0 |

| DeepSeek-Coder 6,7B | 65,1 |

| DeepSeek-Coder 1,3B | 52,4 |

Analyse:

- DeepSeek-Coder 33B schlägt Code Llama 34B und gehört zu den besten Open-Source-Code-Modellen

- Selbst die 6,7B-Version übertrifft StarCoder 15B, was DeepSeek’s Effizienz zeigt

2. Multi-Sprachen-Code-Verständnis (MultiPL-E Benchmark)

DeepSeek-Coder performt gut über verschiedene Sprachen:

- Python: ★★★★★

- JavaScript: ★★★★☆

- C++: ★★★★☆

- Java: ★★★★☆

Fazit: Es ist nicht nur ein Python-Spezialist – sondern ein vielseitiger Multi-Sprachen-KI-Coder.

DeepSeek-Coder vs. Andere Coding-KIs

| Modell | Lizenz | Stärken | Schwächen |

|---|---|---|---|

| DeepSeek-Coder 33B | Apache 2.0 | Beste Open-Source-Leistung | Benötigt starke GPU |

| Code Llama 34B | Custom (Meta) | Guter Allrounder | Lizenzbeschränkungen |

| StarCoder 2 15B | BigCode Open RAIL-M | Leichtgewichtig | Geringere Genauigkeit |

| GitHub Copilot (GPT-4 basiert) | Proprietär | Industriestandard | Bezahlmodell |

Warum DeepSeek-Coder wählen?

✔ Echt Open-Source – Keine restriktiven Lizenzen (im Gegensatz zu Code Llama)

✔ Überlegene Genauigkeit – Schlägt StarCoder und konkurriert mit Code Llama

✔ Skalierbare Optionen – Von 1,3B (lokal) bis 33B (Unternehmensklasse)

Wann Alternativen in Betracht ziehen?

- Wenn Sie eine vollständig gehostete SaaS-Lösung (wie GitHub Copilot) bevorzugen

- Wenn Ihre Hardware nicht einmal das 1,3B-Modell handeln kann

Praktische Anwendungen

1. KI-gestützte Code-Vervollständigung

- Integration mit VS Code (über Erweiterungen wie Continue.dev)

- Funktioniert offline, anders als GitHub Copilot

2. Automatisiertes Debugging

- Erkennt Syntaxfehler, logische Probleme und schlägt Korrekturen vor

3. Modernisierung von Legacy-Code

- Erklärt und refaktoriert alte Codebasen (z.B. COBOL → Python)

4. Vorbereitung auf technische Interviews

- Generiert LeetCode-ähnliche Lösungen mit Erklärungen

Wie verwendet man DeepSeek-Coder?

1. Download von Hugging Face

2. Lokale Ausführung (Beispiel mit 6,7B)

bash

Copy

pip install transformers torch

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained("deepseek-ai/deepseek-coder-6.7b")

tokenizer = AutoTokenizer.from_pretrained("deepseek-ai/deepseek-coder-6.7b")

input_text = "# Python-Funktion zur Fakultätsberechnung"

inputs = tokenizer(input_text, return_tensors="pt")

outputs = model.generate(**inputs, max_length=200)

print(tokenizer.decode(outputs[0]))

3. Quantisierte Versionen für einfache Hardware

- Nutzen Sie GGUF-Formate mit llama.cpp für CPU-only-Betrieb

Endgültiges Urteil: Ist DeepSeek-Coder die beste Open-Source-Coding-KI?

✅ Ja, wenn Sie wollen:

- Eine kostenlose, leistungsstarke Alternative zu GitHub Copilot

- Volle Kontrolle über Ihre KI-Programmierhilfe (keine Cloud-Abhängigkeit)

- Multi-Sprachen-Support über Python hinaus

❌ Nein, wenn Sie:

- Eine vollständig verwaltete SaaS-Lösung bevorzugen

- Keine GPU-Ressourcen zur Verfügung haben

Zukunftsaussicht

Mit DeepSeek-V3 wahrscheinlich in Vorbereitung könnten wir bald noch größere und effizientere Coding-Modelle sehen.